Os Videogames São o Último Benchmark de IA?

Durante anos, a avaliação de modelos de IA dependeu de benchmarks como MMLU, Chatbot Arena e SWE-Bench Verified. Mas com a evolução da IA, até especialistas como Andrej Karpathy questionam se esses métodos ainda são válidos.

Sua última preocupação? Os benchmarks de IA estão perdendo confiabilidade – e a resposta para uma melhor avaliação pode estar nos videogames.

Afinal, a IA tem uma longa história nos jogos. O DeepMind mudou o mundo com o AlphaGo derrotando campeões de Go. A OpenAI dominou o Dota 2, provando que a IA pode superar jogadores humanos em estratégia.

Agora, pesquisadores do Hao AI Lab da UC San Diego avançaram mais. Criaram uma IA “agente de jogos” de código aberto para testar LLMs em jogos de quebra-cabeça em tempo real – começando com o Super Mario Bros..

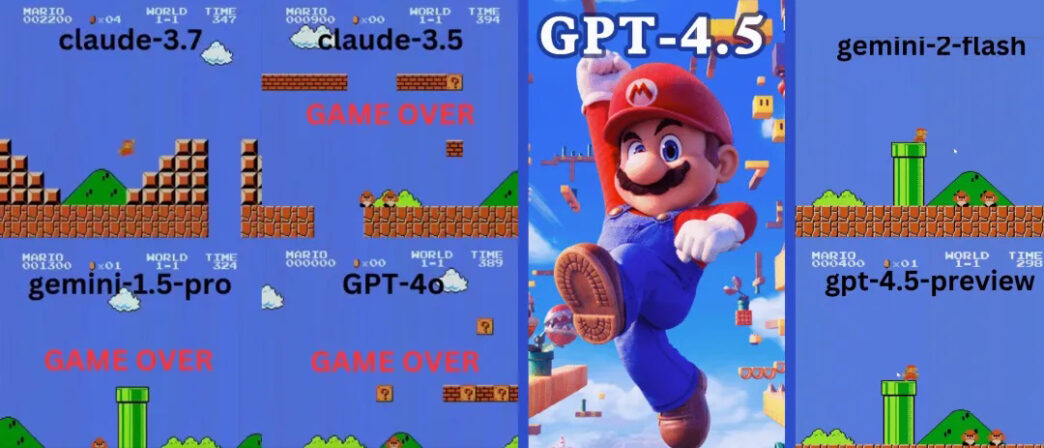

Resultados? O Claude 3.7 jogou 90 segundos inteiros – esmagando o GPT-4o da OpenAI, que morreu quase imediatamente.

Claude 3.7 Supera OpenAI e Google no Super Mario

O projeto GamingAgent, disponível para download open-source, permite que modelos de IA controlem personagens usando linguagem natural.

🔹 Claude 3.7 Sonnet durou impressionantes 90 segundos.

🔹 GPT-4o morreu em 20 segundos – derrotado pelo primeiro inimigo!

🔹 Gemini 1.5 Pro e Gemini 2.0 da Google tiveram desempenho ruim, falhando em movimentos básicos.

GPT-4o: A IA Que Não Sabe Pular

Imagine um jogador tão ruim que morre em segundos. Esse é o GPT-4o no Super Mario.

- 💀 Primeira tentativa: Morto pelo primeiro inimigo, como um iniciante total.

- 💀 Segunda tentativa: Quase não progrediu, parando a cada dois passos.

- 💀 Terceira tentativa: Ficou preso sob

O Gemini 1.5 Pro também falhou logo no primeiro inimigo. Porém, na segunda tentativa, mostrou alguma melhora – acertou um bloco de interrogação e pegou um Super Mushroom.

No entanto, desenvolveu um hábito estranho: pular a cada dois passos – fosse necessário ou não.

- 🚀 Pulou 9 vezes em curta distância

- 🚀 Saltou sobre canos, terreno e até espaços vazios

- 🚀 Chegou mais longe que o GPT-4o mas ainda caiu em um buraco

O Gemini 2.0 Flash foi ligeiramente melhor, pulando com mais fluidez e alcançando uma plataforma mais alta. Mas ainda assim não conseguiu escapar de um buraco perto do quarto cano – encerrando seu jogo.

Claude 3.7: O Pródigo do Super Mario?

Ao contrário dos modelos da OpenAI e Google, o Claude 3.7 jogou como um verdadeiro jogador.

- ✔ Só pulava quando necessário (para evitar obstáculos ou abismos)

- ✔ Evitou inimigos com saltos precisos

- ✔ Descobriu um power-up estrela escondido!

- ✔ Chegou ao ponto mais distante comparado a todas as outras IAs

As IAs podem dominar jogos mais complexos?

Mario não é o único teste. Os pesquisadores também avaliaram modelos de IA em Tetris e 2048, dois clássicos jogos de quebra-cabeça que exigem tomada de decisão estratégica.

GPT-4o falha no 2048 – Claude 3.7 tem desempenho superior

No quebra-cabeça numérico 2048, a IA precisava deslizar blocos e fazer movimentos estratégicos.

🔹 GPT-4o falhou cedo, analisando excessivamente os movimentos.

🔹 Claude 3.7 durou mais, fazendo fusões mais inteligentes.

🔹 Nenhum modelo venceu – mas Claude superou o GPT-4o.

Desempenho do Claude 3.7 no Tetris impressiona especialistas

Quando testado no Tetris, o Claude 3.7 demonstrou:

✔ Estratégia decente para empilhar peças

✔ Limpeza adequada de linhas

✔ Sobrevivência mais longa que outros modelos de IAAlex Albert da Anthropic elogiou o experimento, afirmando:

“Deveríamos transformar todos os videogames em benchmarks de IA!”

Os jogos são o futuro da avaliação de IA?

Os resultados sugerem que videogames podem se tornar o próximo grande padrão de avaliação para IA. Diferente de testes tradicionais, jogos exigem tomada de decisão em tempo real, adaptabilidade e habilidades motoras.

Com os modelos de IA avançando rapidamente, benchmarks estáticos podem não ser mais suficientes para julgar a verdadeira inteligência. Se os jogos se mostrarem uma medida melhor, poderemos ver modelos de IA treinando com aprendizado por reforço em milhares de jogos antes da implantação.

Considerações finais: Claude vence esta rodada, mas o que vem depois?

A jogabilidade superior do Claude 3.7 sugere raciocínio e adaptabilidade mais fortes em comparação com GPT-4o e Gemini. Mas conforme a IA evolui, qual modelo será o primeiro a vencer um jogo completo como um humano?

Com agentes de jogos de código aberto disponíveis, espere mais batalhas de IA vs. videogame em breve. Quem sabe? Talvez um dia a IA complete Super Mario sem erros – ou até derrote jogadores profissionais de esports.

Até lá, Claude permanece o rei dos jogos de IA – enquanto o GPT-4o precisa de muita prática!